特斯拉:不要相信马斯克对自动驾驶的宣传、可能是假的

不要相信马斯克关于AutoPilot的说明,因为可能是假的!

这是特斯拉在AutoPilot致死案审讯中发表的立场。

(资料图片)

(资料图片)

这起和特斯拉自动驾驶有关、导致意外致命的事故,死者的家人们认为马斯克关于特斯拉自动驾驶功能的言论存在误导性。

但特斯拉方面表示,不应该质疑这些言论,因为马斯克常年是Deepfake的受害者。

不过根据法官裁定,马斯克必须要出庭对自己的言论作证了。

特斯拉:马斯克的话都是深度伪造的

特斯拉之所以会发表这个立场,是因为在特斯拉AutoPilot致死案中,原告律师想要让马斯克出庭作证。

死者家属认为,死者过于相信AutoPilot原因之一就是马斯克对AutoPilot和FSD发表的言论。

比如在2016年,马斯克就说过,“目前,Model S和Model X可以实现比人更安全的自动驾驶。”

但特斯拉反对让马斯克出庭作证的要求,因为他们认为马斯克的这些话很可能是Deepfake合成的。

Deepfake,一种由机器学习带来的AI技术,可以生成完全虚拟的视频或者音频。比如换脸视频,或者伪造的音频。

△左:马斯克;右:Deepfake生成的马斯克

所以很多人都会用Deepfake来让一些名人说他们没说过的话,或者在视频里做他们没做过的事。

特斯拉方面表示,马斯克无法回忆起那些言论的细节,因为马斯克和很多公众人物一样,是许多Deepfake视频和录音的素材,所以也不必自证。

但审理该案件的法官表示,特斯拉的这种论点“令人深感不安”。

特斯拉的立场是,由于马斯克很有名,而且更容易成为Deepfake的目标,因此他的公开声明不受约束。

这意味着马斯克等这类名人可以在公共场合想说啥就说啥,还不用对自己的言行负责。因为即使后来有人追究,也能用Deepfake开脱。

至于原告具体会引用马斯克说过的什么,有待后续报道。但至少特斯拉和马斯克,确实造假过。

FSD宣传视频造假

本次事件的核心,还是2018年那起华人苹果工程师的车祸。

这位工程师因为入职苹果,买了一辆当时最好的Model X,从特斯拉的宣传到销售,都给他强调特斯拉的不同之处就是领先的自动驾驶能力。

而在某天驾车回家过程中,他放心于AutoPilot模式,进入高速公路后车辆却径直撞上了路障。车辆损毁严重,他在送往医院中不治身亡。

虽然后续调查中显示,事故发生时,死者在玩手机并没有及时接管,因此这场事故的最终责任人是死者,而不是特斯拉。

但死者的家属还是将特斯拉告上法庭,认为特斯拉存在产品设计缺陷、未发出警告、违反保证、故意和疏忽的虚假陈述以及虚假广告。

特斯拉当时的回应称这起事故是用户使用不当、未能及时接管导致的车祸,和自己的AutoPilot没有关系。

不过在这起案件审理过程中,却发现了一个惊人的事实:特斯拉FSD宣传视频造假。

视频中车辆顺畅地从私人住宅开到特斯拉总部,其实是因为系统里有提前做好的环境建模。

系统早就知道自己要走什么样的路线、怎么走,并不是视频暗示的那样,特斯拉的驾驶系统具备实时感知、决策的能力。

另外,视频开头展示的“驾驶员仅因为法规要求坐在驾驶位,没有操作汽车”也是假的,原视频中司机有过紧急干预接管,不过被剪掉了。

最后自动泊车场景下,车辆也没有能自己找空余车位,拍摄时车辆其实撞到了停车场的护栏。

一句话总结,宣传视频里展示的特斯拉驾驶系统具备的三域贯通驾驶能力,其实都是视频剪辑、拼凑后得到的,系统的真实能力存疑。

那这个视频是谁要求的呢?马斯克。

他亲自布置任务,让AutoPilot团队做出这个视频,并且全程参与、指导剪辑效果。

而特斯拉方面对这个视频的解释是,这并非向用户承诺当时交付的功能,而是展示特斯拉在未来研发中会给车辆搭载什么功能。

毕竟当时这个视频的标题是“Full self-driving hardware on all Teslas”,所有特斯拉车辆上的自动驾驶硬件,的确没有陈述这是交付即用。

特斯拉和马斯克很会玩文字游戏。

而这次,当证据从特斯拉的宣传视频变为马斯克说过的话时,特斯拉也试图用“名气大容易被Deepfake,因此不必自证”来开脱。

但法官和听证会都不买账,已经勒令马斯克在诉讼中出庭作证。

法官表示,马斯克可能会接受长达三个小时的讯问,关于他曾对AutoPilot和FSD发表的言论。

对此,马斯克和特斯拉没有回应。

新闻传送门:

https://www.reuters.com/legal/elon-or-deepfake-musk-must-face-questions-autopilot-statements-2023-04-26/

标签:

-

特斯拉:不要相信马斯克对自动驾驶的宣传、可能是假的 特斯拉:不要相信马斯克对自动驾驶的宣传、可能是假的

特斯拉:不要相信马斯克对自动驾驶的宣传、可能是假的 特斯拉:不要相信马斯克对自动驾驶的宣传、可能是假的 -

10.18万起 比亚迪驱逐舰05冠军版上市:亏电油耗低至3.8L 10 18万起比亚迪驱逐舰05冠军版上市:亏电油耗低至3 8L

10.18万起 比亚迪驱逐舰05冠军版上市:亏电油耗低至3.8L 10 18万起比亚迪驱逐舰05冠军版上市:亏电油耗低至3 8L -

天天速讯:一特斯拉Model S街头起火:“哨兵模式”拍下全过程 一特斯拉ModelS街头起火:“哨兵模式”拍下全过程

天天速讯:一特斯拉Model S街头起火:“哨兵模式”拍下全过程 一特斯拉ModelS街头起火:“哨兵模式”拍下全过程 -

奔驰“付费解锁性能”服务降价了:每月60美元就能跑更快 奔驰“付费解锁性能”服务降价了:每月60美元就能跑更快

奔驰“付费解锁性能”服务降价了:每月60美元就能跑更快 奔驰“付费解锁性能”服务降价了:每月60美元就能跑更快 -

天天速读:首款百万售价比亚迪!仰望U8动力信息曝光:纯电180km、零百最快3.6s 首款百万售价比亚迪!仰望U8动力信息曝光:纯电180km、零百最快3 6s

天天速读:首款百万售价比亚迪!仰望U8动力信息曝光:纯电180km、零百最快3.6s 首款百万售价比亚迪!仰望U8动力信息曝光:纯电180km、零百最快3 6s -

“五一”假期高速免费五天!提前出发的过省界收费站时注意时间 视点 “五一”假期高速免费五天!提前出发的过省界收费站时注意时间

“五一”假期高速免费五天!提前出发的过省界收费站时注意时间 视点 “五一”假期高速免费五天!提前出发的过省界收费站时注意时间

-

去化率是什么意思 去化率多少才能不烂尾? 去化率是什么意思在房地产行业中,去化率是一个非常重要的指标,它通常用来衡量一个开发商或一个项目的销售情况。简单来说,去化率就是指一

去化率是什么意思 去化率多少才能不烂尾? 去化率是什么意思在房地产行业中,去化率是一个非常重要的指标,它通常用来衡量一个开发商或一个项目的销售情况。简单来说,去化率就是指一 -

薛之谦本人到不了薛之谦演唱会 春晚节目单有薛之谦吗? 薛之谦本人到不了薛之谦演唱会4月27日,薛之谦发文透露自己因为堵车没赶上飞机,后续查了也都没票了,他无奈表示:随便给我个下下下班的站

薛之谦本人到不了薛之谦演唱会 春晚节目单有薛之谦吗? 薛之谦本人到不了薛之谦演唱会4月27日,薛之谦发文透露自己因为堵车没赶上飞机,后续查了也都没票了,他无奈表示:随便给我个下下下班的站 -

赤水河发源地源于哪里 赤水河全长多少公里? 赤水河发源地源于哪里?赤水河是中国南方重要的河流之一,发源于贵州省境内。那么,赤水河的发源地源于哪里呢?本文将从多个方面对此问题进行

赤水河发源地源于哪里 赤水河全长多少公里? 赤水河发源地源于哪里?赤水河是中国南方重要的河流之一,发源于贵州省境内。那么,赤水河的发源地源于哪里呢?本文将从多个方面对此问题进行 -

第二届未来中医药发展大会在成都召开|全球通讯 “第二届未来中医药发展大会”于2023年4月27日-28日在成都盛大召开。大会现场此次大会由中国医药新闻信息协

第二届未来中医药发展大会在成都召开|全球通讯 “第二届未来中医药发展大会”于2023年4月27日-28日在成都盛大召开。大会现场此次大会由中国医药新闻信息协 -

英语六级阅读满分多少分 过了英语六级很牛吗? 英语六级阅读满分多少分?英语六级CET6考试总分为710分,其中英语六级阅读满分为248 5分,占整张试卷分值的35%。其中选词填空占5% 10个题,

英语六级阅读满分多少分 过了英语六级很牛吗? 英语六级阅读满分多少分?英语六级CET6考试总分为710分,其中英语六级阅读满分为248 5分,占整张试卷分值的35%。其中选词填空占5% 10个题, -

县委大院在哪里拍摄 县委大院是真实故事吗? 县委大院在哪里拍摄陶冲湖公园陶冲湖公园位于合肥市新站区中国片剂产业基地的核心区域。依托现有的陶冲水库,园区将建成高科技人才接待服务

县委大院在哪里拍摄 县委大院是真实故事吗? 县委大院在哪里拍摄陶冲湖公园陶冲湖公园位于合肥市新站区中国片剂产业基地的核心区域。依托现有的陶冲水库,园区将建成高科技人才接待服务 -

抖音橱窗带货有风险吗?怎么赚钱?|全球观点 在抖音这个平台上面,大家一般想要通过这个平台赚钱,其中最简单的方式就是带货,那么开通橱窗,是大家选

抖音橱窗带货有风险吗?怎么赚钱?|全球观点 在抖音这个平台上面,大家一般想要通过这个平台赚钱,其中最简单的方式就是带货,那么开通橱窗,是大家选 -

摇滚乐的特点有哪些 摇滚乐分为哪几种类型? 摇滚乐的特点有哪些?一、节奏感强烈摇滚乐的最大特点就是强烈的节奏感。通常使用的乐器有鼓、贝斯、吉他等,这些乐器的声音可以产生强烈的

摇滚乐的特点有哪些 摇滚乐分为哪几种类型? 摇滚乐的特点有哪些?一、节奏感强烈摇滚乐的最大特点就是强烈的节奏感。通常使用的乐器有鼓、贝斯、吉他等,这些乐器的声音可以产生强烈的 -

长江入海口在哪个城市 鄱阳湖是长江入海口吗 ? 长江入海口在哪个城市长江是中国最长的河流,也是世界第三长的河流,流经11个省市,最终注入东海。而长江的入海口位于中国江苏省南通市通州

长江入海口在哪个城市 鄱阳湖是长江入海口吗 ? 长江入海口在哪个城市长江是中国最长的河流,也是世界第三长的河流,流经11个省市,最终注入东海。而长江的入海口位于中国江苏省南通市通州 -

旭阳集团董事长许明哲荣获全国五一劳动奖章 为认真贯彻落实习近平总书记关于大力弘扬劳模精神、劳动精神、工匠精神系列重要讲话精神,隆重纪念五一国际劳动节。4月27日上午,吉林省暨

旭阳集团董事长许明哲荣获全国五一劳动奖章 为认真贯彻落实习近平总书记关于大力弘扬劳模精神、劳动精神、工匠精神系列重要讲话精神,隆重纪念五一国际劳动节。4月27日上午,吉林省暨 -

特斯拉:不要相信马斯克对自动驾驶的宣传、可能是假的 特斯拉:不要相信马斯克对自动驾驶的宣传、可能是假的

特斯拉:不要相信马斯克对自动驾驶的宣传、可能是假的 特斯拉:不要相信马斯克对自动驾驶的宣传、可能是假的 -

淄博175美少女接送游客非官方行为 淄博怎么读? 淄博175美少女接送游客非官方行为4月27日,网传山东淄博为了迎接五一来吃烧烤的游客,派出一群1米75青春美少女骑电驴接送。视频画面显示,1

淄博175美少女接送游客非官方行为 淄博怎么读? 淄博175美少女接送游客非官方行为4月27日,网传山东淄博为了迎接五一来吃烧烤的游客,派出一群1米75青春美少女骑电驴接送。视频画面显示,1 -

非法放贷1.4亿 西安“套路贷”案主犯一审被判十七年 4月28日,西安市新城区人民法院依法对被告人肖某等16人“套路贷”涉黑一案进行公开宣判。法院经审理查明,2

非法放贷1.4亿 西安“套路贷”案主犯一审被判十七年 4月28日,西安市新城区人民法院依法对被告人肖某等16人“套路贷”涉黑一案进行公开宣判。法院经审理查明,2 -

贵阳微创胃肠医院;胃镜检查报告中常见的几种诊断结果,你知道什么意思吗? 做过胃镜的朋友应该都知道,胃镜检查报告中最重要的是这3个部分:镜下图片、镜下所见的文字描述、诊断结果。拿到一张报告,很多人会觉得自

贵阳微创胃肠医院;胃镜检查报告中常见的几种诊断结果,你知道什么意思吗? 做过胃镜的朋友应该都知道,胃镜检查报告中最重要的是这3个部分:镜下图片、镜下所见的文字描述、诊断结果。拿到一张报告,很多人会觉得自 -

Nexperia推出先进的I2C GPIO扩展器产品组合 采用创新的可配置上拉电阻和引脚兼容封装奈梅亨,2023年4月28日:基础半导体器件领域的高产能生产专家Nexpe

Nexperia推出先进的I2C GPIO扩展器产品组合 采用创新的可配置上拉电阻和引脚兼容封装奈梅亨,2023年4月28日:基础半导体器件领域的高产能生产专家Nexpe -

世上无难事的下一句是什么 世上无难事是谁的名言? 世上无难事的下一句是什么世上无难事,只怕有心人。这句话的下一句是:只要肯努力,事事都能成。这句话告诉我们,只要我们付出努力,就能够

世上无难事的下一句是什么 世上无难事是谁的名言? 世上无难事的下一句是什么世上无难事,只怕有心人。这句话的下一句是:只要肯努力,事事都能成。这句话告诉我们,只要我们付出努力,就能够 -

清明节回娘家对谁不好 清明节出行吉利吗? 清明节为什么不能回娘家在我国民间素来便有清明节不能回娘家过的说法,关于清明节不能回娘家的习俗在一定程度上是受到传统男权思想的影响,

清明节回娘家对谁不好 清明节出行吉利吗? 清明节为什么不能回娘家在我国民间素来便有清明节不能回娘家过的说法,关于清明节不能回娘家的习俗在一定程度上是受到传统男权思想的影响, -

游戏股午后持续拉升,多股20%涨停 36氪获悉,游戏股午后持续拉升,板块指数大涨超10%,掌趣科技、顺网科技、冰川网络、宝通科技20%涨停,世纪

游戏股午后持续拉升,多股20%涨停 36氪获悉,游戏股午后持续拉升,板块指数大涨超10%,掌趣科技、顺网科技、冰川网络、宝通科技20%涨停,世纪 -

借条无还款日期怎么要债 借条过了还款日期还有效吗? 借条无还款日期怎么要债1、借条没有还款日期或欠条没有还款日期,实际并不影响借条或者欠条的法律效力,对债权债务的形成也没有什么影响,

借条无还款日期怎么要债 借条过了还款日期还有效吗? 借条无还款日期怎么要债1、借条没有还款日期或欠条没有还款日期,实际并不影响借条或者欠条的法律效力,对债权债务的形成也没有什么影响, -

军营观察丨群山之间,我们眺望天空与海洋 群山之间,我们眺望天空与海洋■于洋清晨,红日缓缓从群山间升起,曦光洒向北部战区海军某场站整齐停放的战

军营观察丨群山之间,我们眺望天空与海洋 群山之间,我们眺望天空与海洋■于洋清晨,红日缓缓从群山间升起,曦光洒向北部战区海军某场站整齐停放的战 -

欠债不还可以让担保人还么 法院让找担保人啥意思? 欠债不还可以让担保人还么1 欠债不还是可以让担保人还的,担保人如果有承诺连带责任的话,债权人是可以将债务人或者担保人作为被告向人民法

欠债不还可以让担保人还么 法院让找担保人啥意思? 欠债不还可以让担保人还么1 欠债不还是可以让担保人还的,担保人如果有承诺连带责任的话,债权人是可以将债务人或者担保人作为被告向人民法 -

一方虚构债务离婚要如何处理 离婚虚构债务怎样辨别欠条? 一方虚构债务离婚要如何处理1、一方虚构债务离婚时,可以起诉至人民法院,请求人民法院查明事实,人民法院经审核事实和证据后,认定为虚构

一方虚构债务离婚要如何处理 离婚虚构债务怎样辨别欠条? 一方虚构债务离婚要如何处理1、一方虚构债务离婚时,可以起诉至人民法院,请求人民法院查明事实,人民法院经审核事实和证据后,认定为虚构 -

有效欠条满足什么条件 欠条可以注明长期有效吗? 有效欠条满足什么条件1、有效欠条需要满足以下条件:(1)写下欠条是欠款人的真实意愿;(2)欠款人具有相应的民事行为能力;(3)没有恶意串通损害

有效欠条满足什么条件 欠条可以注明长期有效吗? 有效欠条满足什么条件1、有效欠条需要满足以下条件:(1)写下欠条是欠款人的真实意愿;(2)欠款人具有相应的民事行为能力;(3)没有恶意串通损害 -

借条担保人多久有效期担保 担保人被起诉如何自保? 借条担保人多久有效期担保1、保证人与债权人未约定保证期间的,借条担保人的有效期为六个月。借条中有保证人的,要写明保证的额度和保证的

借条担保人多久有效期担保 担保人被起诉如何自保? 借条担保人多久有效期担保1、保证人与债权人未约定保证期间的,借条担保人的有效期为六个月。借条中有保证人的,要写明保证的额度和保证的 -

发现他人故意损害庄稼能报警吗 破坏庄稼多少才立案? 发现他人故意损害庄稼能报警吗可以报警,这属于故意毁坏财物,应当承担法律责任,如果价值过大,还需要承担刑事责任。法律依据:《中华人民

发现他人故意损害庄稼能报警吗 破坏庄稼多少才立案? 发现他人故意损害庄稼能报警吗可以报警,这属于故意毁坏财物,应当承担法律责任,如果价值过大,还需要承担刑事责任。法律依据:《中华人民 -

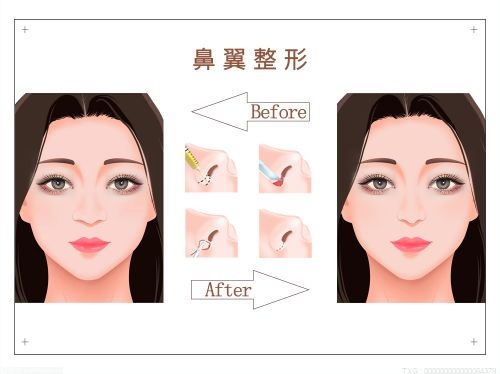

出现医美事故怎么报案 医美投诉是哪个部门? 出现医美事故怎么报案?出现医美事故报案的方式是拨打110电话,但是医美事故属于民事纠纷,即使公安机关出警了也只是进行调解。受害者可以与

出现医美事故怎么报案 医美投诉是哪个部门? 出现医美事故怎么报案?出现医美事故报案的方式是拨打110电话,但是医美事故属于民事纠纷,即使公安机关出警了也只是进行调解。受害者可以与 -

有劳动合同借款贷款怎么操作 贷款房贷需要劳动合同吗? 有劳动合同借款、贷款怎么操作有劳动合同的,可以拿着相关复印件进行申请借款。有劳动合同和工资流水说明劳动者具有稳定的工作和收入来源,

有劳动合同借款贷款怎么操作 贷款房贷需要劳动合同吗? 有劳动合同借款、贷款怎么操作有劳动合同的,可以拿着相关复印件进行申请借款。有劳动合同和工资流水说明劳动者具有稳定的工作和收入来源, -

有一台小货车可以报废吗 小货车强制报废怎么处理? 有一台小货车可以报废吗小货车报废是要符合一定的标准的,符合条件的情况下可以申请报废。货车报废标准如下:1、装有单缸发动机的低速货车

有一台小货车可以报废吗 小货车强制报废怎么处理? 有一台小货车可以报废吗小货车报废是要符合一定的标准的,符合条件的情况下可以申请报废。货车报废标准如下:1、装有单缸发动机的低速货车 -

信用卡逾期怎么和银行协商还款 停息挂账自己怎么去申请? 信用卡逾期怎么和银行协商还款?无论你是因为什么样的原因导致无法及时还清信用卡的欠款,都一定要主动和银行联系,用客观的理由来和银行方

信用卡逾期怎么和银行协商还款 停息挂账自己怎么去申请? 信用卡逾期怎么和银行协商还款?无论你是因为什么样的原因导致无法及时还清信用卡的欠款,都一定要主动和银行联系,用客观的理由来和银行方 -

芸豆和豆角的区别是什么 豆角和芸豆是一个东西吗? 芸豆和豆角的区别是什么?作为常见的蔬菜,芸豆和豆角在市场上常常被混淆,很多人不知道它们之间的区别。其实,芸豆和豆角虽然都属于豆科植

芸豆和豆角的区别是什么 豆角和芸豆是一个东西吗? 芸豆和豆角的区别是什么?作为常见的蔬菜,芸豆和豆角在市场上常常被混淆,很多人不知道它们之间的区别。其实,芸豆和豆角虽然都属于豆科植 -

秋膘是什么意思 贴秋膘是长胖的意思吗? 秋膘是什么意思这是一个常见的问题,尤其在中国农村地区。秋膘指的是在秋季开始增加体重,以备冬季需要的一种行为。这种行为在农村地区的家

秋膘是什么意思 贴秋膘是长胖的意思吗? 秋膘是什么意思这是一个常见的问题,尤其在中国农村地区。秋膘指的是在秋季开始增加体重,以备冬季需要的一种行为。这种行为在农村地区的家 -

神兽是什么意思 为什么把小孩子称为神兽? 神兽是什么意思神兽是指孩子的意思,是家长对自家孩子的一种称呼。用神兽这个词来形容孩子,绝不是褒义词,而是一种苦涩的调侃式讽刺,但也

神兽是什么意思 为什么把小孩子称为神兽? 神兽是什么意思神兽是指孩子的意思,是家长对自家孩子的一种称呼。用神兽这个词来形容孩子,绝不是褒义词,而是一种苦涩的调侃式讽刺,但也 -

法大大刘谦:数智签约,助力企业创新 4月26日,国内领先的电子合同和电子签云服务平台法大大举办了以数智‘签’引,万物生长为主题的春季产品发布会,并推出全新一代

法大大刘谦:数智签约,助力企业创新 4月26日,国内领先的电子合同和电子签云服务平台法大大举办了以数智‘签’引,万物生长为主题的春季产品发布会,并推出全新一代 -

大学生用5.12地震攻击成都球迷,校方通报:发表不当言论,记过处分_环球微动态 【大学生用512地震攻击成都球迷】4月27日,@中国医科大学发布情况通报:26日,我校学生刘某某在微博平台通

大学生用5.12地震攻击成都球迷,校方通报:发表不当言论,记过处分_环球微动态 【大学生用512地震攻击成都球迷】4月27日,@中国医科大学发布情况通报:26日,我校学生刘某某在微博平台通 -

医联推出国内首款 AI 医生 medGPT,计划 5 月正式发布

-世界微动态 IT之家4月28日消息,医联官方微信公众号今日更新文章,宣布正式发布国内首款大模型驱动的AI医生——medGPT

医联推出国内首款 AI 医生 medGPT,计划 5 月正式发布

-世界微动态 IT之家4月28日消息,医联官方微信公众号今日更新文章,宣布正式发布国内首款大模型驱动的AI医生——medGPT -

闪耀AWE | 美而浦联合建发居住科技打造生活全场景新净界! 在很多人眼中,2023是充满希望和憧憬的一年,也是各行业扭转颓势、奋发追赶的一年。特别是阔别已久的AWE2023,今年吸引了众多国际一线品牌

闪耀AWE | 美而浦联合建发居住科技打造生活全场景新净界! 在很多人眼中,2023是充满希望和憧憬的一年,也是各行业扭转颓势、奋发追赶的一年。特别是阔别已久的AWE2023,今年吸引了众多国际一线品牌 -

天天时讯:经济日报郭言:美大搞经济胁迫违背公平正义 最近一段时间,美国一些政客对中国发展的“焦虑症”愈发严重,先是在亚洲地区组建所谓“芯片四方联盟”,后

天天时讯:经济日报郭言:美大搞经济胁迫违背公平正义 最近一段时间,美国一些政客对中国发展的“焦虑症”愈发严重,先是在亚洲地区组建所谓“芯片四方联盟”,后 -

Magic5系列海外市场发力,荣耀高端手机业务逆势增长

IT之家4月28日消息,据IDC最新发布的中国手机市场报告显示,2023年第一季度,国内市场手机出货量约为6,544

Magic5系列海外市场发力,荣耀高端手机业务逆势增长

IT之家4月28日消息,据IDC最新发布的中国手机市场报告显示,2023年第一季度,国内市场手机出货量约为6,544 -

环球观速讯丨广州拼消费,拼得有多猛 作者:老古当下的中国,正在全力以赴拼经济。提振消费,成为了经济发展的核心之一。特别在这个经济复苏的关

环球观速讯丨广州拼消费,拼得有多猛 作者:老古当下的中国,正在全力以赴拼经济。提振消费,成为了经济发展的核心之一。特别在这个经济复苏的关 -

山西移动助力三晋首邑绽放智慧乡村“新业新貌”-每日报道 “千里一曲,曲当其阳”。太原市阳曲县史称“三晋首邑”,过去曾因交通不便、靠天吃饭,一度成为“山西省定

山西移动助力三晋首邑绽放智慧乡村“新业新貌”-每日报道 “千里一曲,曲当其阳”。太原市阳曲县史称“三晋首邑”,过去曾因交通不便、靠天吃饭,一度成为“山西省定 -

李佳琦不仅是公益出色的主播,更是公益领域的先行者 李佳琦一直都保持着非常忙碌的工作状态。为了确保综艺节目《所有女生的主播》能够按时拍摄和播出,他每天都要从上午11点一直工作到晚上7点

李佳琦不仅是公益出色的主播,更是公益领域的先行者 李佳琦一直都保持着非常忙碌的工作状态。为了确保综艺节目《所有女生的主播》能够按时拍摄和播出,他每天都要从上午11点一直工作到晚上7点 -

天天速讯:一特斯拉Model S街头起火:“哨兵模式”拍下全过程 一特斯拉ModelS街头起火:“哨兵模式”拍下全过程

天天速讯:一特斯拉Model S街头起火:“哨兵模式”拍下全过程 一特斯拉ModelS街头起火:“哨兵模式”拍下全过程 -

抖音播放量有收益吗?播放量一千万能挣多少钱? 在抖音有很多的网红,还有很多的大V,他们的帐号粉丝都是非常多的,一个视频发布出去观看量也是非常多,

抖音播放量有收益吗?播放量一千万能挣多少钱? 在抖音有很多的网红,还有很多的大V,他们的帐号粉丝都是非常多的,一个视频发布出去观看量也是非常多, -

施耐德电气徐韶峰:以持续创新为“两型建设”提供核心动力 近年来,伴随着可持续发展和能源转型的大势所趋,电力能源行业的创新和变革从未止步。此前,为全面贯彻落实党的二十大精神,加快规划建设新型能

施耐德电气徐韶峰:以持续创新为“两型建设”提供核心动力 近年来,伴随着可持续发展和能源转型的大势所趋,电力能源行业的创新和变革从未止步。此前,为全面贯彻落实党的二十大精神,加快规划建设新型能 -

淘宝55划算节活动玩法是什么?有哪些招商要求? 淘宝55划算节活动还有十几天就要开始了,买家除了关注活动优惠之外还想知道淘宝55划算节活动玩法,那么今年

淘宝55划算节活动玩法是什么?有哪些招商要求? 淘宝55划算节活动还有十几天就要开始了,买家除了关注活动优惠之外还想知道淘宝55划算节活动玩法,那么今年 -

2023年三亚市医保政策知识竞赛举办-焦点短讯 4月26日,市医疗保障局举办以“安全规范用基金,守好人民‘看病钱’”为主题的2023年三亚市医保政策知识竞

2023年三亚市医保政策知识竞赛举办-焦点短讯 4月26日,市医疗保障局举办以“安全规范用基金,守好人民‘看病钱’”为主题的2023年三亚市医保政策知识竞 -

天猫精灵智能眼镜发布:搭载骨导喇叭和智控语音助手,899 元

IT之家4月28日消息,据IT之家网友反馈,天猫精灵近日推出了——天猫精灵智能眼镜,定价899元,5月9日20:00

天猫精灵智能眼镜发布:搭载骨导喇叭和智控语音助手,899 元

IT之家4月28日消息,据IT之家网友反馈,天猫精灵近日推出了——天猫精灵智能眼镜,定价899元,5月9日20:00 -

棕榈股份:把“绿色”写满祖国大地 暮春之际,伴随着河南重大项目建设的冲锋号,在河南开封、信阳潢川、鹤壁淇滨等多地项目施工现场,棕榈生态城镇发展股份有限公司(以下简称

棕榈股份:把“绿色”写满祖国大地 暮春之际,伴随着河南重大项目建设的冲锋号,在河南开封、信阳潢川、鹤壁淇滨等多地项目施工现场,棕榈生态城镇发展股份有限公司(以下简称 -

德国卡赫携多款新品亮相AWE 2023,以科技致净美好生活 2023年中国家电及消费电子博览会(AWE 2023)于4月27日至30日在上海新国际博览中心举办,全球清洁行业领军者德国卡赫闪耀亮相,于超200平

德国卡赫携多款新品亮相AWE 2023,以科技致净美好生活 2023年中国家电及消费电子博览会(AWE 2023)于4月27日至30日在上海新国际博览中心举办,全球清洁行业领军者德国卡赫闪耀亮相,于超200平 -

IMIS爱美丽新品舒适内衣,解锁夏日内搭的美丽“密码” 天气渐渐转热,女生们是不是越来越想换掉不透气的内衣?别纠结,IMIS来帮你!夏日内搭,当然要舒适自然。IMIS爱美丽全新推出小冰皮系列,选

IMIS爱美丽新品舒适内衣,解锁夏日内搭的美丽“密码” 天气渐渐转热,女生们是不是越来越想换掉不透气的内衣?别纠结,IMIS来帮你!夏日内搭,当然要舒适自然。IMIS爱美丽全新推出小冰皮系列,选

热门资讯

-

旭阳集团董事长许明哲荣获全国五一劳动奖章 为认真贯彻落实习近平总书记关于大...

旭阳集团董事长许明哲荣获全国五一劳动奖章 为认真贯彻落实习近平总书记关于大... -

贵阳微创胃肠医院;胃镜检查报告中常见的几种诊断结果,你知道什么意思吗? 做过胃镜的朋友应该都知道,胃镜检...

贵阳微创胃肠医院;胃镜检查报告中常见的几种诊断结果,你知道什么意思吗? 做过胃镜的朋友应该都知道,胃镜检... -

法大大刘谦:数智签约,助力企业创新 4月26日,国内领先的电子合同和电...

法大大刘谦:数智签约,助力企业创新 4月26日,国内领先的电子合同和电... -

闪耀AWE | 美而浦联合建发居住科技打造生活全场景新净界! 在很多人眼中,2023是充满希望和憧...

闪耀AWE | 美而浦联合建发居住科技打造生活全场景新净界! 在很多人眼中,2023是充满希望和憧...

观察

图片新闻

-

2023年三亚市医保政策知识竞赛举办-焦点短讯 4月26日,市医疗保障局举办以“安...

2023年三亚市医保政策知识竞赛举办-焦点短讯 4月26日,市医疗保障局举办以“安... -

微头条丨大型探伤车国产自研系统在海南铁路西环货线“首秀”检测成功 4月24日至26日,由中车集团株洲时...

微头条丨大型探伤车国产自研系统在海南铁路西环货线“首秀”检测成功 4月24日至26日,由中车集团株洲时... -

三亚崖州区“多坟山”显“真容” 4月27日,工作人员在崖州学宫清点...

三亚崖州区“多坟山”显“真容” 4月27日,工作人员在崖州学宫清点... -

【报资讯】三亚市旅行社协会发布“五一”假期诚信经营倡议书 4月27日,三亚市旅行社协会发布“...

【报资讯】三亚市旅行社协会发布“五一”假期诚信经营倡议书 4月27日,三亚市旅行社协会发布“...

精彩新闻

-

当前快报:北京“五一”期间将举办811场文化活动 2023年“五一”假期即将到来。记者...

当前快报:北京“五一”期间将举办811场文化活动 2023年“五一”假期即将到来。记者... -

“表里山河 晋享春意”山西文化和旅游主题季活动启动 为持续提振山西文旅市场信心,加快...

“表里山河 晋享春意”山西文化和旅游主题季活动启动 为持续提振山西文旅市场信心,加快... -

支付宝怎么绑亲情卡?有额度限制吗? 目前在支付宝中可以绑定亲情卡,...

支付宝怎么绑亲情卡?有额度限制吗? 目前在支付宝中可以绑定亲情卡,... -

10.18万起 比亚迪驱逐舰05冠军版上市:亏电油耗低至3.8L 10 18万起比亚迪驱逐舰05冠军版上...

10.18万起 比亚迪驱逐舰05冠军版上市:亏电油耗低至3.8L 10 18万起比亚迪驱逐舰05冠军版上... -

环球速讯:一场生死游戏!《饥饿游戏:鸣鸟与蛇》首曝预告 1905电影网讯《饥饿游戏》系列前传...

环球速讯:一场生死游戏!《饥饿游戏:鸣鸟与蛇》首曝预告 1905电影网讯《饥饿游戏》系列前传... -

大量用户反映收到“自己”发来的骚扰广告,淘宝称正排查

IT之家4月28日消息,近日有网友在...

大量用户反映收到“自己”发来的骚扰广告,淘宝称正排查

IT之家4月28日消息,近日有网友在... -

重庆文化旅游惠民消费季又来了!超千万、最高四折消费券这样领 天天热点评 清音演唱、喜剧表演相继登场,新鲜...

重庆文化旅游惠民消费季又来了!超千万、最高四折消费券这样领 天天热点评 清音演唱、喜剧表演相继登场,新鲜... -

即时看!支付宝花呗上征信吗?如何开通支付宝花呗? 支付宝花呗是我们经常使用的功能,...

即时看!支付宝花呗上征信吗?如何开通支付宝花呗? 支付宝花呗是我们经常使用的功能,... -

快手小店如何设置限时秒杀?附详细流程-通讯 快手商家想要提高商品销量,除了推...

快手小店如何设置限时秒杀?附详细流程-通讯 快手商家想要提高商品销量,除了推... -

广西桂林:铁路通信“操盘手”助力枢纽车站站房“搏动”更有力 4月23日22时30分,南宁通信段桂林...

广西桂林:铁路通信“操盘手”助力枢纽车站站房“搏动”更有力 4月23日22时30分,南宁通信段桂林... -

奔驰“付费解锁性能”服务降价了:每月60美元就能跑更快 奔驰“付费解锁性能”服务降价了:...

奔驰“付费解锁性能”服务降价了:每月60美元就能跑更快 奔驰“付费解锁性能”服务降价了:... -

铁路上海站迎来今年以来单日最高客流 预计发送旅客55.8万人次-天天观天下 记者从铁路上海站(下辖上海站、上...

铁路上海站迎来今年以来单日最高客流 预计发送旅客55.8万人次-天天观天下 记者从铁路上海站(下辖上海站、上... -

热门:地方造车败局考:尴尬上饶 继梳理了南京、如皋、南阳几个地方...

热门:地方造车败局考:尴尬上饶 继梳理了南京、如皋、南阳几个地方... -

环球今头条!内蒙古科技馆要身份证吗? 内蒙古科技馆要身份证吗?必备:身...

环球今头条!内蒙古科技馆要身份证吗? 内蒙古科技馆要身份证吗?必备:身... -

山东省第十四届“小飞天”奖儿童舞蹈大赛4月29日在山东省会大剧院举行_今日报 由山东省文学艺术界联合会、山东省...

山东省第十四届“小飞天”奖儿童舞蹈大赛4月29日在山东省会大剧院举行_今日报 由山东省文学艺术界联合会、山东省... -

石洲社区-焦点快报 1、石洲社区为中国福建省漳州市龙...

石洲社区-焦点快报 1、石洲社区为中国福建省漳州市龙... -

每日观察!销量低迷亏损严重,三菱汽车在中国暂停新车生产 日前,据日经新闻报道,从2023年3...

每日观察!销量低迷亏损严重,三菱汽车在中国暂停新车生产 日前,据日经新闻报道,从2023年3... -

动画电影《蜘蛛侠:纵横宇宙》中国独家预告公布,内地定档6月2日

... IT之家4月28日消息,蜘蛛侠系列电...

动画电影《蜘蛛侠:纵横宇宙》中国独家预告公布,内地定档6月2日

... IT之家4月28日消息,蜘蛛侠系列电... -

一季度大宗交易市场投资热度下降,写字楼依旧最受青睐 世界速看 综合来看,2023年一季度的大宗交易...

一季度大宗交易市场投资热度下降,写字楼依旧最受青睐 世界速看 综合来看,2023年一季度的大宗交易... -

华为智能门锁系列亮相 AWE 2023:全方位展示智慧安全优势

每日讯息 在刚刚举办的以“智科技,创未来”...

华为智能门锁系列亮相 AWE 2023:全方位展示智慧安全优势

每日讯息 在刚刚举办的以“智科技,创未来”... -

2023年抗血清抗毒素概念上市公司股票一览(4月28日)-环球讯息 2023年抗血清抗毒素概念上市公司股...

2023年抗血清抗毒素概念上市公司股票一览(4月28日)-环球讯息 2023年抗血清抗毒素概念上市公司股... -

淘宝优惠券在哪个app领比较好?有哪些渠道? 当前快播 其他小伙伴们都会去网购,那么就...

淘宝优惠券在哪个app领比较好?有哪些渠道? 当前快播 其他小伙伴们都会去网购,那么就... -

天天速读:首款百万售价比亚迪!仰望U8动力信息曝光:纯电180km、零百最快3.6s 首款百万售价比亚迪!仰望U8动力信...

天天速读:首款百万售价比亚迪!仰望U8动力信息曝光:纯电180km、零百最快3.6s 首款百万售价比亚迪!仰望U8动力信... -

今日观点!IT之家iOS/安卓版8.65发布:耳听大事,「昨夜今晨」语音播报上线

IT之家iOS版 安卓版8 65正式发布...

今日观点!IT之家iOS/安卓版8.65发布:耳听大事,「昨夜今晨」语音播报上线

IT之家iOS版 安卓版8 65正式发布... -

全球微动态丨英特尔 2023 一季度营收 117 亿美元,同比下降 36%

IT之家4月28日消息,英特尔今天公...

全球微动态丨英特尔 2023 一季度营收 117 亿美元,同比下降 36%

IT之家4月28日消息,英特尔今天公... -

中式悬疑解谜游戏《纸嫁衣4:红丝缠》上线Steam商城,首发28.8元

-每日报道 IT之家4月28日消息,中式悬疑解谜...

中式悬疑解谜游戏《纸嫁衣4:红丝缠》上线Steam商城,首发28.8元

-每日报道 IT之家4月28日消息,中式悬疑解谜... -

空天动力陕西实验室试验测试基地落户咸阳 总投资22.6亿 4月26日,空天动力陕西实验室试验...

空天动力陕西实验室试验测试基地落户咸阳 总投资22.6亿 4月26日,空天动力陕西实验室试验... -

2022年广西检察机关共受理知识产权案件80件 同比增长48.15% 时讯 4月25日,广西壮族自治区人民检察...

2022年广西检察机关共受理知识产权案件80件 同比增长48.15% 时讯 4月25日,广西壮族自治区人民检察... -

淘宝引入魔方是真的吗?有什么用? 全球新要闻 淘宝平台有很多的小伙伴们会去开...

淘宝引入魔方是真的吗?有什么用? 全球新要闻 淘宝平台有很多的小伙伴们会去开... -

《边狱巴士公司》进不去解决方法 边狱巴士公司是一款回合制策略对战...

《边狱巴士公司》进不去解决方法 边狱巴士公司是一款回合制策略对战... -

做淘宝联盟怎么推广简单有效?有哪些技巧? 现在大家在做淘宝的时候一般选择...

做淘宝联盟怎么推广简单有效?有哪些技巧? 现在大家在做淘宝的时候一般选择... -

淘宝有多少商家入驻?淘宝商家运营技巧-今日讯 随着淘宝平台的不断壮大,在淘宝开...

淘宝有多少商家入驻?淘宝商家运营技巧-今日讯 随着淘宝平台的不断壮大,在淘宝开... - 从江门“狂飙”到“梦回”长安,爱奇艺随刻创作之旅如何赋能城市文旅? 《隐秘的角落》播出一周,湛江的旅...

-

淘宝美工是做什么的工作内容?附详情|天天看热讯 现在淘宝美工是指在淘宝平台上负...

淘宝美工是做什么的工作内容?附详情|天天看热讯 现在淘宝美工是指在淘宝平台上负... -

走向世界 目标星河 蒙牛要强二十载携手中国航天点亮未来 2023年4月27日,蒙牛与中国航天基金...

走向世界 目标星河 蒙牛要强二十载携手中国航天点亮未来 2023年4月27日,蒙牛与中国航天基金... -

中国白酒七子,向世界文化遗产“出征” 中国白酒、中国文化又向全球化征程...

中国白酒七子,向世界文化遗产“出征” 中国白酒、中国文化又向全球化征程... -

有机豆浆粉,成长好营养|龙王为中国儿童膳食营养健康持续助力 儿童是国家未来,民族的希望。促进...

有机豆浆粉,成长好营养|龙王为中国儿童膳食营养健康持续助力 儿童是国家未来,民族的希望。促进... -

追得集团携手捷途大圣,带你体验全新柔性显示黑科技 你对智能驾舱的期待是什么?第三空...

追得集团携手捷途大圣,带你体验全新柔性显示黑科技 你对智能驾舱的期待是什么?第三空... -

酸枣仁怎样吃_如何食用酸枣仁 欢迎观看本篇文章,小升来为大家解...

酸枣仁怎样吃_如何食用酸枣仁 欢迎观看本篇文章,小升来为大家解... -

【当前热闻】杂交水稻年亩产4000斤高产技术集成项目在海南三亚收割 首季稻三亚亩... 4月27日,杂交水稻年亩产4000斤高...

【当前热闻】杂交水稻年亩产4000斤高产技术集成项目在海南三亚收割 首季稻三亚亩... 4月27日,杂交水稻年亩产4000斤高... -

西北民族大学在哪里 西北民族大学算名校吗? 西北民族大学在哪里西北民族大学在...

西北民族大学在哪里 西北民族大学算名校吗? 西北民族大学在哪里西北民族大学在... -

有才无德是什么意思 德才兼备比喻什么人? 有才无德是什么意思有才无德是指一...

有才无德是什么意思 德才兼备比喻什么人? 有才无德是什么意思有才无德是指一... -

【世界快播报】换标五菱!上汽名爵在印度推出电动车“Comet EV”:当地最便宜 换标五菱!上汽名爵在印度推出电动...

【世界快播报】换标五菱!上汽名爵在印度推出电动车“Comet EV”:当地最便宜 换标五菱!上汽名爵在印度推出电动... -

投入中国本土研发,宝马是认真的|天天快消息 今年的上海车展,燃油车几乎不再成...

投入中国本土研发,宝马是认真的|天天快消息 今年的上海车展,燃油车几乎不再成... -

阿拉木图是哪个国家的 阿拉木图离中国哪里最近? 阿拉木图是哪个国家的这个问题可能...

阿拉木图是哪个国家的 阿拉木图离中国哪里最近? 阿拉木图是哪个国家的这个问题可能... -

恒大汽车全面停产,开始破产倒计时? 天天亮点 恒大汽车全面停产了。停产理由是,...

恒大汽车全面停产,开始破产倒计时? 天天亮点 恒大汽车全面停产了。停产理由是,... -

南通通州:百亿企业设百岗“春风”吹开“助残花” “肢体方面能否胜任简单机械操作?...

南通通州:百亿企业设百岗“春风”吹开“助残花” “肢体方面能否胜任简单机械操作?... -

什么动物天生有高血压 天生高血压能控制好吗? 什么动物天生有高血压高血压是动物...

什么动物天生有高血压 天生高血压能控制好吗? 什么动物天生有高血压高血压是动物... -

快讯:环卫女工用汗水擦亮城市容颜 这双沟壑纵横的手的主人叫李文香,...

快讯:环卫女工用汗水擦亮城市容颜 这双沟壑纵横的手的主人叫李文香,... -

重庆大巴侧翻致20伤 大巴车容易侧翻吗? 重庆大巴侧翻致20伤:7人伤势较重5...

重庆大巴侧翻致20伤 大巴车容易侧翻吗? 重庆大巴侧翻致20伤:7人伤势较重5...